- 0

- 0

- 0

分享

- 人工智能也会踩高拜低么?

-

2021-07-10

随着人工智能渗透到日常生活的更多层面,随之而来的是人工智能滥用的负面影响也更加凸出。当人工智能开始对人类产生歧视时,我们该如何面对?而人工智能为什么会对人们有歧视呢?本期小编将和大家一起展开讨论。

Part 1

被放大的

歧视

科技的发展始终来自于人,人工智能更是如此。曾经我们对人工智能的理解可能是冷漠又冰冷的机器,它们没有人情世故,也不懂人性的共情。然而在现如今,人工智能技术随着科技的发展并不再只是冷冰冰的机器,它们不仅可以帮助我们解决问题、与我们对话,还能在一定程度上自我学习。

性别平等

“为什么这个图像识别的人工智能,老把男人认成女人?”

人工智能识别花草动物已经很普遍的在我们生活中应用,对于面部识别的技术也很成熟,分辨男女更不是什么世纪难题。但在实际生活中却不是如此,面对复杂的背景环境,人工智能经常会出现性别的识别错误。

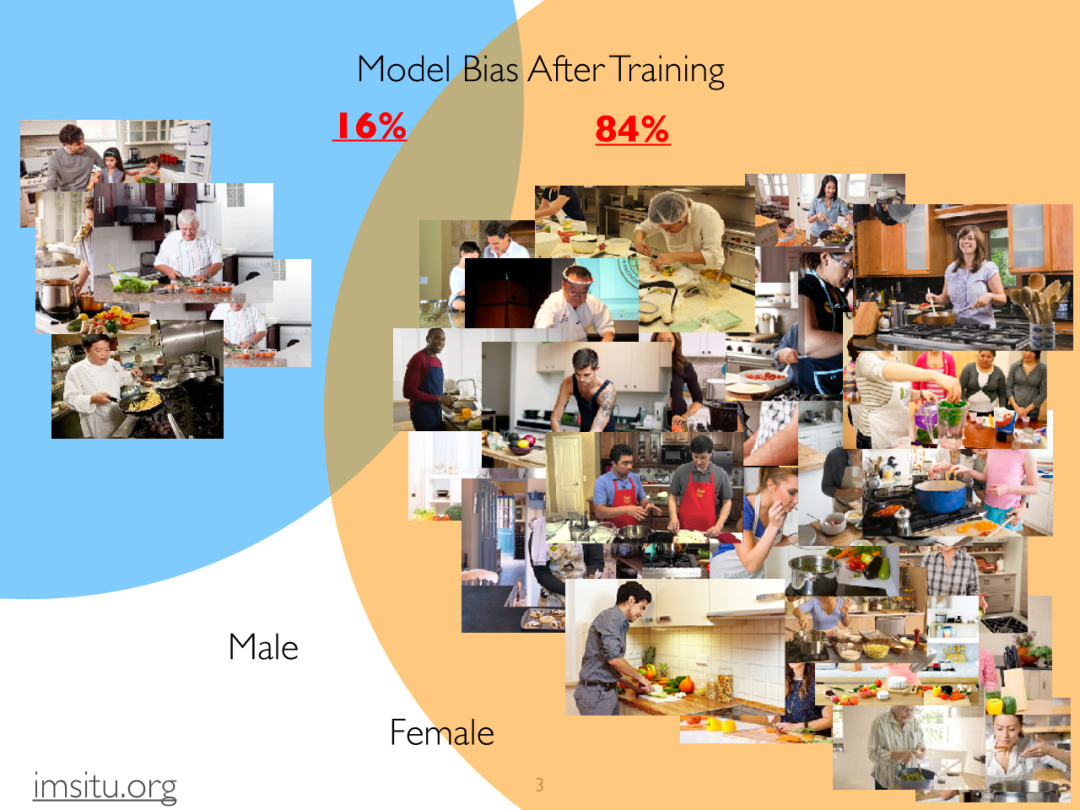

在EMNLP2017最佳论文“Men also like shopping: reducing genderbias amplification using corpus-level constraints”中作者赵洁玉和她的团队关于如何减少机器学习模型的数据偏见问题进行了研究,发现在相似的背景环境下,人工智能往往会把行为和性别联系在一起,在厨房做饭的场景中84%被认为是女性,只有16%是男性,这与图片的实际性别并不相符。

数据库识别偏差

在ImSitu和MSCOCO两个最为代表的图像训练数据集中,一些标签和性别绑定的程度十分突出,比如在厨房里、做家务、照顾孩子的会被认为是女性,而开会、办公、从事体育运动的则是男性。在这样的数据背景下,如果一个男性在洗衣做饭,人工智能很大程度会识别为女性。

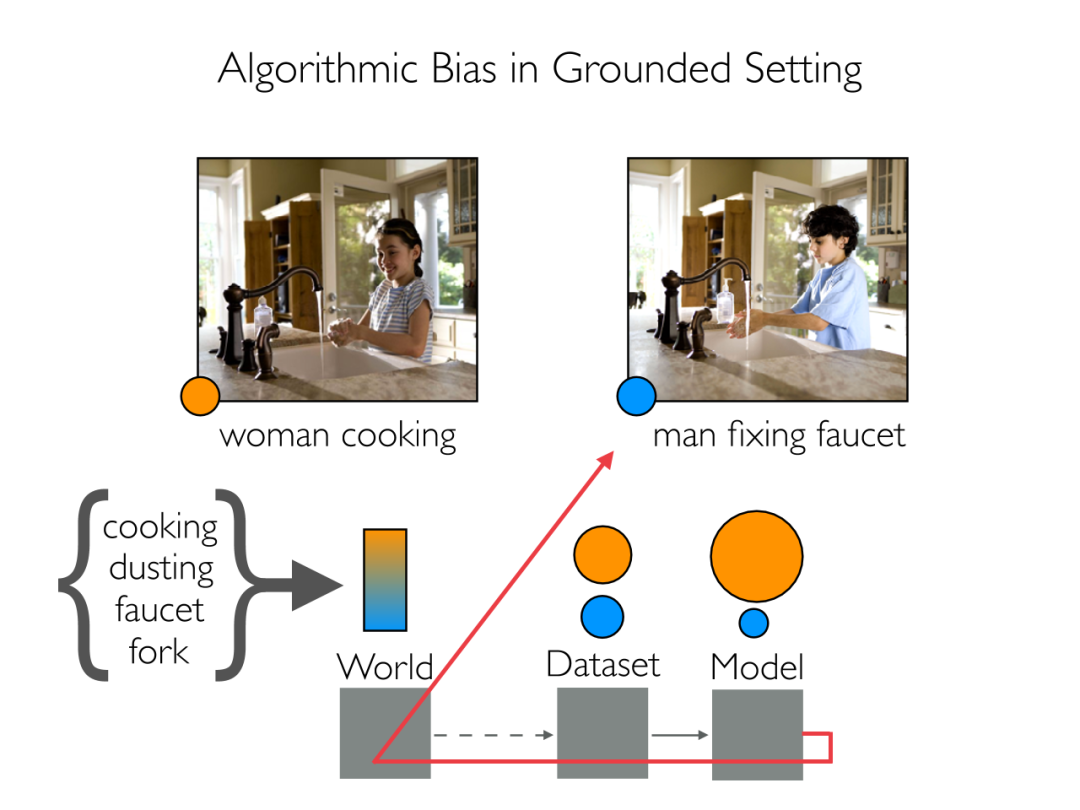

相同环境相同动作不同性别的图像

人工智能给出的识别内容并不相同

数据集是机器学习的基础,如果数据集本身缺乏代表性,就不能够客观地反映现实情况。在数据集上训练的人工智能不仅反映了数据库中的这些偏差,而且放大了它们。人工智能不会创造新的偏见,而它会放大已有的偏见。

Part 2

歧视的

始作俑者

计算机科学中有一句话:垃圾进,垃圾出。当我们向人工智能提供反映我们偏见的数据时,它们会学习到有偏见的数据,讲我们针对的歧视放大。

这样的歧视是怎么产生的呢?其实很简单。如果你成长在一个“男主外、女主内”的社会,那么你便会天然地认为女人就该操持家务。人工智能也一样,不过它“认识世界”的途径、也是歧视的来源,是它的“教学资料”——用于训练人工智能进行图像识别的数据库。

数据传输

正如一些数据科学家所言,什么样的输入就有什么样的产出,没有好的数据,算法也做不出正确的决策。

最典型的例子就是微软的聊天机器人Tay,就曾经学会了人类的那些极端言论,在Twitter上咒骂女权主义者和犹太人。

聊天机器人Tay

在一定程度上,人工智能的歧视实际上是人类偏见的一种显现和强化。尽管人工智能技术是一个客观的存在,但技术的目的是为了服务与人,在人工智能算法在诞生前就已经被概念化,并且在开发的过程中必然伴随着开发者的意志。

机器与人

亚马逊公司曾被爆出在简历筛选中出现性别歧视,原本应该公平公正、没有意识的AI,学会了重男轻女、歧视女性。其原因是这个人工智能学习的都是来自亚马逊过去10年来收到的简历,依据这些简历,亚马逊的人工智能学会了挑出男性求职者。

amazon招聘会

人工智能的歧视其实产生于人类的实际生活中,像谷歌、苹果、微软、Facebook这些公司,整体上男性占了2/3,而单独挑出技术岗位,男性比例则达到了将近4/5。换句话说,人工智能是从人类社会中,学会了人类的偏见和歧视。

Part 3

AI歧视

是一面镜子

言及至此,我们应该很清楚种族主义或性别歧视等人工智能对人类歧视的问题并非来自于深度学习机器本身,而是来自于创造它的人。

人创造人工智能

人工智能发展到现在,并没有很长的时间。如果把它比作婴儿,那它的成长有很大一部分依靠人类给予的养分与教育。在训练人工智能的过程中,所输入的数据便是养分。人类应该尽力将算法调整到中立、客观,即使数据中出现了一个小的偏差,人工智能的最终行为也会将这个偏差放大。我们如何看待社会,人工智能也会以相同的视角去看待社会。

去年年初,谷歌宣布图像标记AI工具将不再使用“男人”和“女人”等性别标签来标记图片,今后将会使用“Person”(人物)来标记图像,以避免人工智能算法传达出偏见。人工智能倾向于分类为男女两种性别,但在“男”和“女”之外,还有其它性别认同,谷歌此举体现了它对跨性别者和非跨性别者更具包容性。这是科技公司面对人工智能歧视的改变与优化,在人工智能行业树立一个先例。

人与机器共生

对我们而言AI歧视可以作为一面镜子,让我们发现生活中的不平等,进而去改进和完善。古人「以铜为鉴,可正衣寇;以古为鉴,可知兴替;以人为鉴,可明得失」或许在如今这个数字科技时代,我们也可「以AI为镜,以去偏见」。

对于人工智能歧视你是怎么看呢?留言告诉我们吧!

号外!号外!

国际交互艺术夏令营即将截止申请

《移形幻影》

等你来学

编辑:ERDONG

审核:OF君

未经授权 请勿转载

参考资料:

https://www.un.org/zh/chronicle/article/20459

https://news.un.org/en/story/2020/12/1080192

https://www.techbeat.net/talk-info?id=375

https://www.reuters.com/article/us-amazon-com-jobs-automation-insight/amazon-scraps-secret-ai-recruiting-tool-that-showed-bias-against-women-idUSKCN1MK08G

https://www.huxiu.com/article/332033.html

-

阅读原文

* 文章为作者独立观点,不代表数艺网立场转载须知

- 本内容由数艺网主动采集收录,信息来源为 “OF COURSE想当然” 公开网络发布内容。第三方如需转载本内容,必须完整标注原作者信息及 “来源:数艺网”,严禁擅自篡改、删减或未标注来源转载。 并附上本页链接: 若您的内容不希望被数艺网收录,或认为此举侵犯了您的合法权益,敬请通过微信 ID:d-arts-cn 联系数艺网。我们将致以诚挚歉意,并第一时间为您办理下架或删除处理。