- 0

- 0

- 0

分享

- 暂停大型语言模型实验的请愿书及其批判:跨越人工智能的“卢比孔河”

-

2023-05-09

梁正 清华大学人工智能国际治理研究院副院长、人工智能治理研究中心主任、中国科技政策研究中心副主任、公共管理学院教授

导言:

在过去的半年里,当世界主要国家仍然疲于应对硅谷银行倒闭所引发的系统性金融风险时,当美国对TikTok展开举世瞩目的围追堵截时,生成式人工智能(Generative AI)却在科技与金融行业的动荡中暗渡陈仓,呈现出“井喷式”发展。

3月8日,在收购了Open AI后,微软旋即发文宣布ChatGPT在可视化模型的帮助下拥有了视觉理解和图像生成能力,由此引爆了人工智能领域的军备竞赛。在短短一个月的时间里,顶尖高校、科研机构、初创企业轮番上阵,谷歌、亚马逊、Meta等科技巨头各显神通,众多基于不同模型的生成式人工智能工具如雨后春笋般涌现。它们也从最初回答人类问题时的“驴唇不对马嘴”迅速变为能够在短短几秒内生成图片、文字、数据分析乃至视频的强大存在。科技公司英伟达(Nvidia)的执行长黄仁勋(Jen-Hsun Huang)化用曾经带来移动互联网革命的iPhone传奇,将ChatGPT的“风靡”比作AI行业的“苹果手机时刻”(The iPhone Moment)

与此相伴生的则是风险投资行业的狂热。例如,巴黎一家仅有2名员工的初创人工智能公司Dust,其股份便被以红杉资本为代表的英美风险投资公司竞相争夺。根据 PitchBook的数据,自2022年初以来,金融行业对人工智能类初创公司的投资已从2020年15亿美元激增至59 亿美元。而行业分析机构互联网数据中心(International Data Corporation,简称IDC)则预测2023年全球人工智能(包括以人工智能为中心的系统的软件、硬件和服务)支出将达到惊人的1540亿美元,同比增长26.9%。我们甚至可以大胆猜测,或许以SVB银行和硅谷银行破产为表象的金融科技行业的动荡本身,便与嗅到AI商机的风险投资机构快速调整其资本布局有关。

然而,在科技界与投资界双双陷入“狄奥尼索斯般的癫狂”中时,以埃隆·马斯克为首的一批科技界与商界精英却联名发布公开信,要求暂停一切大型AI实验半年以上,以便为制定一套监督和规范AI发展的协议创造时间,避免因AI失控造成不可挽回的损失与灾难。无独有偶,在ChatGPT还未把科技的曙光洒向世界的每一个角落之前,美国、英国、加拿大、意大利和欧盟等国家和地区的政府、行业与高校已经开始对生成式人工智能威胁和风险表示担忧,并呼吁对其进行监管和限制。

由众多行业精英联袂的请愿书究竟说了什么?生成式人工智能将给人类社会带来怎样的冲击与挑战?政府与社会又会如何管控风险、制定政策?“末日时钟”悄然向零点拨快了几秒钟,在这个将深刻影响人类历史的时刻,每一个人都需要扪心自问:放任还是监管,拥抱还是禁绝,前进还是后退……“To be, or not to be, that is the question.”

请愿书的担忧、诉求与主张

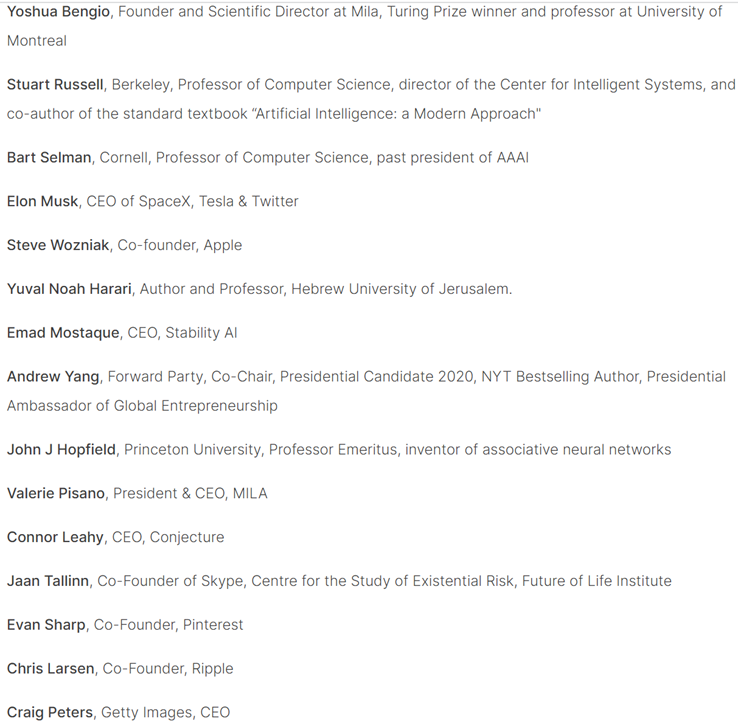

3月22日,美国非营利性智库未来生命实验所(future of life institute,简称FOLI)在自己的官网上刊发了名为《暂停大型AI实验:一封公开信(Pause Giant AI Experiments: An Open Letter)》的请愿书,一时间吸引了广泛的关注。截止目前,FOLI宣称其已经收集了超过30000个签名,并完成了对其中27565个的认证。在这些签名中除了广为人知的特斯拉CEO埃隆·马斯克、苹果联合创始人史蒂夫·沃兹尼亚克、美国前总统候选人杨安泽(Andrew Yang)外,还有众多科学学术界泰斗和科技产业界精英。

请愿书部分完成认证的签字人,包含众多学术界和产业界精英,图源:future of life institute

请愿书的开头便引用十几篇人工智能研究机构的报告,表明具有人类竞争智能(human-competitive intelligence)的AI系统对人类社会具有潜在风险,因而需要相应的监管和规范。然而,人类社会目标并不存在任何针对高级AI的规划和管理。而由ChatGPT引起的生成式人工智能军备竞赛和无序竞争则进一步放大了AI发展中的不可控风险。尤其是大规模AI训练可能产生的意想不到的“黑箱(black box)”。对此,“没有人——甚至他们的创造者——都无法理解,预测,或可靠地控制(no one – not even their creators – can understand, predict, or reliably control)”。

紧接着,请愿书一连抛出涉及知情权、劳动就业权、人类种族安全与可持续发展的四个问题,并提出“只有当我们确信它们的影响是积极的并且它们的风险是可控的时候,才应该开发强大的人工智能系统”。紧接着,它引用了OpenAI最近发布的报告《规划 AGI 及以后(Planning for AGI and beyond)》中的观点,即,在训练未来更为强大的“通用人工智能”)(Artificial General Intelligence,简称AGI)之前应该进行独立审查(independent review)并同意限制算力增长(growth of compute),并指出这些必要措施应马上得到落实。

由此,请愿书提出了四点呼吁。首先,呼吁所有AI实验室立即暂停训练对比GPT-4更强AI系统至少6个月,并保证其公开、透明、可验证,且必要时由政府介入予以保障。其次,人工智能行业内的实验室和独立专家应利用这段时间,共同制定一套用于高级人工智能设计与开发的共享安全协议,并由第三方独立专家进行严格审计和监督。再次,人工智能研究机构在遵守共同协议的情况下,在研发中应保障其人工智能系统本身“更加准确、安全、可解释、透明、稳健、一致、值得信赖和忠诚。(more accurate, safe, interpretable, transparent, robust, aligned, trustworthy, and loyal)”。最后,AI开发人员须进一步和政策制定者合作,尽快开发针对强大AI的治理系统,具体来说包括:

(1)设立专门监管机构;

new and capable regulatory authorities dedicated to AI

(2)监督和跟踪高性能人工智能系统和大量计算能力;

oversight and tracking of highly capable AI systems and large pools of computational capability

(3)出处和水印系统,以帮助区分AI合成品,并跟踪模型泄漏;

provenance and watermarking systems to help distinguish real from synthetic and to track model leaks

(4)一个强大的审计和认证生态系统;

a robust auditing and certification ecosystem

(5)明晰人工智能造成的损害的责任

liability for AI-caused harm

(6)设立扶持人工智能技术安全研究的公共资金

robust public funding for technical AI safety research

(7)设立资源丰富的机构,以应对人工智能将造成的巨大经济和政治混乱

well-resourced institutions for coping with the dramatic economic and political disruptions that AI will cause.

尽管请愿书提及了以往人类社会禁止其他可能造成灾难性后果的技术的经验,例如人类克隆和优生学,但它并非要求彻底禁绝人工智能的发展。甚至,请愿书并不要求在整体上暂停AI的开发,而是更强调应尽快形成某种危机应对机制,避免在无序的人工智能竞赛中出现不可预测的风险与灾难。

对请愿信的批判及对这些批判的批判

虽然这份请愿书得到了众多的支持,但在是否应停止AI训练与开发的问题上,西方科技界产生了巨大的分歧。许多业界精英反对和批判这一主张。他们的批判大致可以分为三类,即反对监管,否认风险和质疑动因。

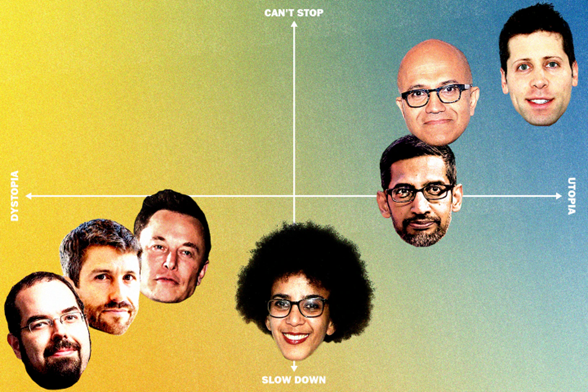

美国科技界人士对于人工智能发展态度的谱系图,图源:华盛顿邮报(从左至右依次是:埃利泽·尤德科夫斯基Eliezer Yudkowsky、特里斯坦·哈里斯Tristan Harris、埃隆·马斯克Elon Musk、蒂姆尼特·格布鲁Timnit Gebru、桑达尔·皮查伊Sundar Pichai、萨蒂亚·纳德拉Satya Nadella和萨姆·奥特曼Sam Altman)

(一)反对外部的干涉与监管

数字货币交易所Coinbase的首席执行官布莱恩·阿姆斯特朗(Brian Armstrong)是公开反对请愿书的众多知名人士中的佼佼者。他在一条推文中表示,委员会和官僚机构解决不了任何问题,也没有“专家”可以决定这个问题。对于通用人工智能可能带来的风险,他“泰然自若”地表示:任何新技术都可能带来一定的风险,既然无论如何都不能避免,我们的目标就应该是推着这项技术不断前进。他在推特上写道:“永远不要让恐惧阻止进步,并警惕任何试图在某种中央集权获得控制权的人(Don’t ever let fear stop progress, and be wary of anyone trying to capture control in some central authority)。”

但仔细阅读请愿书就会发现阿姆斯特丹对其的指控不完全成立。请愿书中虽然提及监管,但并非将监管的权力直接地、彻底地授予政府,而是更强调人工智能企业、研究机构和行业的第一责任,其次是相关的专家,再次是社会力量,政府的介入是作为最后的保障角色存在的。因此,请愿书的监管诉求呈现出主体多元化、管理多层次的特征,并不能简单地将其的要求归结为“中央集权”(central authority)。

而阿姆斯特丹对政府监管如此敏感,与近期以美国为首的西方世界对加密货币的监管与打击力度加大不无关系。但他无疑说出了科技巨头们的心声——反对政府监管人工智能的研发,不过是他们对于技术和利益垄断的公开声明。

(二)不承认AI可能给人类造成的风险,或更强调其他问题

《洛杉矶时报》的专栏作家布赖恩·默钱特(Brian Merchant)将马斯克领导的请愿称为“炒作AI世界末日的嘉年华”(apocalyptic AI hype carnival)。他认为,请愿书中陈述许多的担忧不过是“机器人工作启示录(robot jobs apocalypse)”般的东西。

彭博资讯科技专栏作家帕米·奥尔森 (Parmy Olson)则认为请愿信夸大了生成式人工智能的能力以博取眼球,反而分散了公众对更细微的、更现实的风险的注意力。她表示,目前担心AI取代人类还为时尚早,相反,一些AI已经引起的问题更值得我们关注。譬如,AI开发的垄断性和不透明性、生成式人工智能对于知识产权的侵犯,以及chatGPT大规模引入科技产品与公司系统所带来风险。

对于前者的观点,我们可以援引签署了这封请愿信的纽约大学名誉教授加里·马库斯Gary Marcus的观点进行反驳。他固然批驳过分担忧人工智能近期前景的观点,但他更强调应警惕人工智能在人类无法控制的情况下自我完善,从而产生通用人工智(Artificial General Intelligence,简称AGI)。他担心AGI将被犯罪分子或恐怖分子用以欺骗民众或传播危险的错误信息。

此外,清华大学人工智能国际治理研究院副院长梁正教授也表示,“在近期GPT-4的测试报告中显示,在逻辑推理、理解认知等方面上GPT-4已经超越了某些标准测试当中人类的表现。”这加剧了人们对于继续大模型训练可能导致人工智能失控的担忧。他还引用“曲别针制造机”(paperclip maximizer)思想实验,指出“目前人工智能更迫切的问题不在于其是否会产生自主意识,而在于当算力强大的AI曲解人类的指令时,可控性是否还能得到保障。”

对于后者,我们应该承认其观点有合理性,也和请愿书的诉求存在共性。一方面,其对请愿书的批判并不否认人工智能给人类社会带来的风险和问题,另一方面,其同样赞成对人工智能进行某种监管和规范。她指出的问题只是人工智能监管的次序或先后问题,因此在本质上应该是该请愿书的“盟友”。

(三)对这份请愿信背后的真实意图的怀疑与指控

万事达卡(Mastercard) 的前高管Satvik Sethi 将请愿书称为“AI版本的不扩散条约”(non-proliferation treaty but for AI)。他认为请愿书名单上的许多签署者在AI领域有着深厚的个人既得利益,其要求暂停AI实验只是为了“试图放慢他们的同行,以便他们能够取得成功(trying to slow down their counterparts so they can get ahead)”。

康奈尔大学数字和信息法教授詹姆斯·格里梅尔(James Grimmelmann)则表示,鉴于特斯拉一直试图在完善其无人驾驶汽车上的人工智能系统,埃隆·马斯克签署这份协议是极其虚伪的(deeply hypocritical)。

被称为“人工智能教父”的Meta Platforms(META)首席人工智能科学家杨立昆(Yann LeCun)则用了一种更加隐蔽的方式来表达这种观点。他在推特上嘲讽“今年是1440年,天主教会要求暂停使用印刷机和活字印刷术6个月。想象一下,如果普通人能够接触到书籍,会发生什么?他们可以自己阅读圣经,社会就会被摧毁。”

马斯克 图源:澎湃新闻

此外,还有一些人认为请愿书的观点是精英主导的长期主义(长期主义的态度是专注,始终面向未来,才能穿越周期,用长期的确定性,对抗短期的不确定性)观点,其过分强调精英群体在人类发展中的地位和作用,是对西方民主制的损害。

这些猜测或质疑或许是合理的,乃至真实的

同样不可否认的是,对于人工智能的监管与治理已经成为广受行业内外人士的关注。甚至早在未来生命研究生的请愿信公布以前,3月16日,以欧盟议会议员德拉戈什·图多拉什(Dragoș·Tudorache)为首的12位欧盟政治家已经联盟发布了公开信,呼吁欧盟与美国一起,围绕人工智能的技术开发、控制和部署等管理原则形成一套通用规则。

可以说,无论马斯克签署这封请愿信的时候有没有贰心,无论有没有未来生命协会主导这封请愿信,人工智能的监管都已经到了必要的时刻(本文下一章节对于生成式人工智能已经对人类社会治理与法制造成的冲击的梳理将证明这一点)。

两千多年前,当凯撒伫立于罗马城畔的卢比孔河,沉思是违反共和国法律,率领军队渡过卢比孔河,进入罗马,废除元老院,建立帝国?还是止步河畔,委身共和?他的心里同样也面临着与今天我们面对人工智能冲击时一样的迷茫——To be, or not to be?

但一如在凯撒的时代,实存的罗马共和国在历史运动中必然展开为罗马帝国一般,在我们的时代,实存的生成式人工智能ChatGPT在历史运动中必然引发——且这种引发已经初露端倪——对于人工智能的监管与治理。黑格尔说,在历史的重大运动中,理性主义的原则与自私自利往往汇聚于一处,以至于身在其中的人常常不能将二者区分。马斯克的私心或请愿信不过是历史发展的“理性的狡黠”,是人工智能领域的跨过卢比孔河(Crossing The Rubicon,перейти Рубикон)时刻。

参考文献

-

阅读原文

* 文章为作者独立观点,不代表数艺网立场转载须知

- 本内容由数艺网主动采集收录,信息来源为 “清华大学人工智能国际治理研究院” 公开网络发布内容。第三方如需转载本内容,必须完整标注原作者信息及 “来源:数艺网”,严禁擅自篡改、删减或未标注来源转载。 并附上本页链接: 若您的内容不希望被数艺网收录,或认为此举侵犯了您的合法权益,敬请通过微信 ID:d-arts-cn 联系数艺网。我们将致以诚挚歉意,并第一时间为您办理下架或删除处理。